谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

咱们看智能眼镜好多年了:从早年 Google Glass 的半残念,到这两年苹果 Vision Pro、三星 Galaxy XR 这种高端 MR 头显,再到 Meta、Rokid 做得像能看通知的小眼镜……

但真正能日常戴出门、不像科幻 cosplay、不厚重、也不只是玩具的智能眼镜,一直没出现过。

结果,谷歌突然拿出 Android XR 平台 + 两套自家原型眼镜,XReal 这边又扔出一个更狠的 Project Aura。我亲手戴上去那一刻,脑子里只飘出一句话:

——智能眼镜,这下要真成了。

Android XR:谷歌搞的不是产品,是整个生态的操作系统

先说个关键背景:

Android XR = 专为 XR 设备打造的 Android 系统。

意思就是:以后不管哪个厂想做 MR 头显、智能眼镜,都能用同一套系统,而不是谁都各搞一套。

你可以理解成:

✔ Vision Pro 用的是 visionOS

✔ Meta 用自家闭环系统

✔ Android XR 则是整个安卓阵营的底层标准

以前安卓平板乱成一锅粥,安卓 XR 就是来避免智能眼镜版惨案的。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

谷歌自家的两副眼镜:轻到离谱,但功能已经能打

谷歌这次亮了两副开发套件眼镜:

单目光波导版(更轻)

双目光波导版(能显示 3D 深度)

全无线、眼镜自带电池,所有计算都靠手机,手势控制靠镜腿上的触控区域。

我体验下来,几个亮点非常扎眼:

① YouTube Music 小组件:终于不是科幻 PPT 了

戴着眼镜听歌,眼前会飘出一个小小的播放卡片:

歌曲名、进度、暂停/下一曲,全都有。

→ 清晰度够用

→ 操作手感比大部分智能手表还顺

→ 室内音质 OK,当然硬件还没定型别太当回事

第一次有种智能眼镜的 UI 开始靠谱了的感觉。

② Google Meet 视频通话:对方在你眼前浮着说话

来电 → 轻触镜腿 → 接听。

然后对方的头像就出现在右眼前的悬浮窗口里。

你也能把自己视角(眼镜外摄像头看到的画面)分享过去,

整个过程流畅得超乎想象。

③ Google Maps 导航:现实版小地图来了

问它附近有什么便利店?

选一个后,眼前就出现:

前进方向箭头

距离

向下看时,直接变成一个现实版游戏小地图

我当场热泪盈眶:

终于看到现实中的 AR 导航有点像样了,不是那种 ARKit 演示那一套虚的东西。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

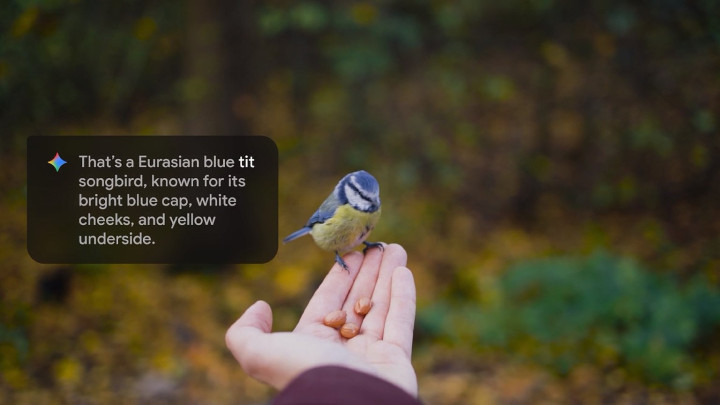

④ AI 识物:Gemini 识食材比我妈都准

Demo 里我盯着几罐意面,它能马上识别:

✔ 面的种类

✔ 旁边的红薯

✔ 还判断出是美式红薯不是日韩那种

这比给我做个菜谱更让我兴奋,因为这是真正能融入日常生活的 AI 感知能力。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

Android XR vs Meta:不是做产品,是做生态底座

从体验来说,Google 这套眼镜和 Meta Ray-Ban Display 非常像:

都能识物

都有语音/AI

都能显示通知、导航

但关键差别是:

Meta 做的是一个单一产品的系统,Android XR 做的是一个行业的系统。

未来如果国内厂商想做智能眼镜,比如:

华为

小米

OPPO

XReal(已经合作了)

理论上都能基于 Android XR 做自己的眼镜。

这就是安卓的力量。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

XReal Project Aura:我没想到 XR眼镜形态可以做到这么强

然后是今天最震撼我的东西——

XReal Project Aura。

一句话总结:

戴起来像眼镜,用起来像 Vision Pro。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

① 用的是棱镜显示,但 FOV 宽到吓人:70°!

对比一下:

一般光波导智能眼镜:30°~40°

XReal One Pro:57°

Project Aura:70°

Galaxy XR 头显:109°(但那是头显,不是眼镜)

效果就是:

你眼前像挂了一块大电影屏幕。

这在眼镜级设备里简直是降维碾压。

② 一个小盒子 = 一台完整的 Android XR 处理器

Project Aura 和手机用线连着一个小盒子,就是它的大脑:

Snapdragon XR2+ Gen 2 同款芯片(和三星 Galaxy XR 一样)

完整运行 Android XR

App、界面、功能全都有

你可以理解成:

“小型化的 Galaxy XR,用眼镜形态重生”

我真的没想到眼镜形态能承载这么重的系统。

③ 手势控制:比 Meta,更像 Vision Pro

最让我惊掉下巴的是:

→ 伸手

→ 指向想点的图标

→ 食指与拇指“捏一下” = 点击

→ 捏住拖动 = 移动窗口

→ 手心翻向自己 + 捏 = 打开菜单

一模一样的 Vision Pro / Galaxy XR 操作方式。

只是这次是在一副眼镜上。

市面所有智能眼镜,包括 Meta、Rokid、雷鸟,都没有这样自然的交互体验。

④ 多窗口、浏览器、地图、3D 游戏,全都能跑

实际使用中我做了:

Chrome 浏览网页

Google Maps 弹出 3D 城市

YouTube 看视频

玩 3D 桌游游戏

还能连 PC 低延迟串流游戏

这体验在智能眼镜领域简直是断代升级。

⑤ 但它也不是万能——还是眼镜级限制

清晰度只有 1080p,不如头显

棱镜让视野透明度不够,不能边走边戴

手部追踪区域比头显更窄

没有眼动追踪,全靠手势指哪点哪

但这些是物理限制,不是产品失败。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了

智能眼镜第一次让我看到真落地的未来

谷歌的开发套件 + Android XR

= 生态底座

XReal Project Aura

= 未来消费级产品长什么样的预告片

智能眼镜终于从“能用但不实用”

迈到

“能实用且有前景”。

可惜的是:

谷歌两副眼镜 → 只卖给开发者

XReal Project Aura → 也是开发套件,不对普通用户销售

真正的消费级 Android XR 智能眼镜 → 最快要等 2026 年底

但就目前体验来看,我脑子里只有一句话:

智能眼镜这盘棋,谷歌 + XReal 已经把新局摆出来了。

谷歌 & XReal 的新一代 XR 智能眼镜上手:这次,我是真被震住了